KI-generiertes Bild von Natalia: Beautiful Blue trends feather pattern texture background, stock.adobe.com.

Transparenz als Allheilmittel?

Soziale Medien im Spannungsfeld von DSA und zivilgesellschaftlichen Problematisierungen

Das Kompetenznetzwerk Gegen Hass im Netz meldete im Februar 2024: 49% von mehr als 3.000 Internetnutzer*innen in Deutschland ab 16 Jahren gaben bei einer Befragung an, schon einmal online belästigt worden zu sein.1 Und weiter: «Hass im Netz kann jeden treffen. Aber nicht alle gleich». Insbesondere marginalisierte Personen und Communities, wie etwa BIPoC-, LGBTQIA+-, weiblich, migrantisch, jüdisch oder muslimisch gelesene Personen sowie Aktivist*innen sind (auch) in digitalen Öffentlichkeiten gefährdet, zu verkörperten Adressen von Anfeindungen und Diffamierungen zu werden. Eingebettet in opake algorithmisierte Empfehlungssysteme entlang kommerzialisierter (Aufmerksamkeits-)Ökonomien sowie durch Neurechte strategisch beeinflusste Netzwerkeffekte eröffnen jene Öffentlichkeiten letztlich, wenn auch nicht ausschließlich, Artikulationsräume für Sexismus, Rassismus, rechte Propaganda, Antisemitismus und weitere Formen gruppenbezogener Menschenfeindlichkeit. Zugleich werden dabei Artikulationsräume von z.B. LGBTQIA+-Communities eingeschränkt oder es stellen sich sogenannte chilling effects2 ein.3 So hat Meta erst im Februar 2024 in einem Blogpost bekannt gegeben: «[...] we [...] don’t want to proactively recommend political content from accounts you don’t follow». Was hier ‹politisch› heißen soll bleibt nebulös. Gleichzeitig werden diese hier aufgeführten realen Gefährdungen im Kontext digitaler Öffentlichkeit von feministischer Seite beständig problematisiert und damit politisiert: So wies das Missy Magazine darauf hin, dass mit Einschränkungen der Sichtbarkeit zu rechnen ist, sofern die Account-Einstellungen (Content Preferences) nicht von den User*innen angepasst werden. Anstelle die Individualisierung gesellschaftlicher Problemlagen hinzunehmen, lieferte das Missy Magazine die passende Anleitung zur Änderung der Account-Einstellungen gleich mit.

Wenn man bei aller Komplexität des Zusammenwirkens ökonomischer, technologischer, juridischer und politischer Bedingungen und damit verbundenen Reibungen versucht auf den Punkt zu bringen, worum es in den Debatten zur machtvollen Regulierung von Öffentlichkeiten im Plattformkontext geht, dann ließe sich das vielleicht so formulieren: Strittig ist, wer oder was auf welcher legitimatorischen Grundlage und vor dem Hintergrund welcher Machtkonstellationen in die Position gesetzt wird, entlang welcher normativen Maßstäbe die öffentliche Debatte zu regulieren. Dabei ist es insbesondere die Intransparenz des Algorithmischen vor dem Hintergrund erheblicher Informations- und Machtasymmetrien zwischen den Betreibenden Sozialer Medien, Nutzer*innen sowie nicht zuletzt Regulierungsbehörden, die längst zu einem zentralen Politikum avanciert ist.

Kulturorganisationen wie das Vagina Museum ebenso wie die ‹Swifties› [...] erinnern uns daran, dass die Konstitution von Öffentlichkeiten nicht nur Staatsaufgabe sein kann und darf.

Hatte bereits das Netzwerkdurchsetzungsgesetz versucht, Plattformen in die Verantwortung zu nehmen und gegen Hate Speech und Fake News vorzugehen, so dürfte spätestens seit dem vollumfänglichen Inkrafttreten des Digital Services Act (DSA) am 17. Februar 2024 kaum noch Zweifel daran bestehen, dass es sich bei sogenannten Very Large Online Platforms (lustiger: VLOPs) um ein Problem mit gesellschaftspolitischer Tragweite handelt. In den Worten Thierry Bretons, dem zuständigen EU-Binnenmarktkommissar, klingt das so: «Es ist an der Zeit, etwas Ordnung in den digitalen Wilden Westen zu bringen». Okay. Insbesondere das Ablegen von Rechenschaft etwa in Form sogenannter ‹Transparenzberichte› wird dabei durch den DSA zu einem fraglichen Allheilmittel stilisiert, mit dem VLOPs in die Verantwortung für jene systemischen Risiken genommen werden könnten, die durch die Verbreitung von Inhalten auf den Plattformen entstehen.

Wie wir noch sehen werden, handelt es sich bei der Regulierung durch den DSA nicht um ein Allheilmittel. Diese Einsicht fordert uns also notwendigerweise und folgerichtig dazu auf, über den Tellerrand der Staatsräson zu schauen und damit eben auch zivilgesellschaftliche Problematisierungen von Plattformen und Netzwerkeffekten sowie neue Formate politischer Bildung in den Blick zu nehmen. Kulturorganisationen wie das Vagina Museum ebenso wie die ‹Swifties› (die Fancommunity von Taylor Swift) erinnern daran, dass die Gestaltung und Problematisierung digitaler Öffentlichkeiten nicht nur Staatsaufgabe sein kann und darf, sondern konstitutiv von jenen abhängt, ohne die Plattformen gar nicht existieren würden: User*innen.

Im Folgenden fokussieren wir auf zwei aktuelle Schauplätze der Problematisierung der Grenzen digitaler Öffentlichkeiten: Erstens die juridische Problematisierung durch rechtliche Regulierung im Kontext des Digital Services Acts (DSA). Vor dem Hintergrund der dabei hervortretenden Kritik am DSA weiten wir unseren Blick zweitens auf zivilgesellschaftliche Problematisierungen und Politisierungen digitaler Öffentlichkeiten aus.

Anstelle Fragen nach der grundsätzlichen Legitimation machtvoller, privat organisierter Plattformstrukturen zu stellen sowie ihre gewaltvollen gesellschaftspolitischen Effekte zu regulieren, legitimieren Transparenzmaßnahmen den Status Quo.

Grundsätzlich ist der DSA ein marktwirtschaftliches Gesetz, das zur Vereinheitlichung des Binnenmarkts beitragen und die Marktmacht großer digitaler Plattformen einhegen soll. Dass wir es mit einem marktwirtschaftlichen Gesetz zu tun haben, welches digitale Öffentlichkeiten zu regulieren sucht, scheint erklärungsbedürftig. Die Besonderheit digitaler Öffentlichkeiten wie Facebook, X, TikTok oder Instagram ist bekanntlich, dass sie von privatwirtschaftlichen Unternehmen gestaltet und moderiert werden. Im Fokus des DSA steht daher das Geschäftsmodell der VLOPs – die Sammlung, Speicherung und der Handel mit Nutzer*innendaten sowie die Anordnung von Content entlang kommerzieller Aufmerksamkeitsmärkte, die darauf abzielt, dass User*innen möglichst lange auf den Plattformen verbleiben. Denn Nutzungszeit und die damit einhergehende Datensammlung sind die Währungen Sozialer Medien.4 Auf Grundlage der massenhaften Sammlung von User*innendaten werden algorithmische Systeme trainiert, die im Zuge prädiktiver Analysen mögliche zukünftige Verhaltensweisen berechnen und vorhersagen. Damit gehen intransparente Kategorisierungen und Gruppierungen von User*innen einher, die sensible Informationen wie Angaben zum Geschlecht, sexuelle Orientierung oder politische Einstellungen umfassen können. Diese Vorhersagen werden im Sinne des Geschäftsmodells der VLOPs verwendet, um Profile zu erstellen und die jeweiligen Feeds mit maßgeschneiderten Inhalten und Werbeanzeigen zu füllen. Idealerweise führen diese angepassten Inhalte zu einer Ausweitung der Nutzungszeit, sodass noch mehr Daten generiert und die Profile erneut angepasst werden können.

Dabei gilt oft: Je polarisierender und kontroverser ein Inhalt, desto aufmerksamkeitserzeugender ist er. So haben die Veröffentlichungen der Whistleblowerin Francis Haugen gezeigt, dass Facebook polarisierende Gefühle wie Wut algorithmisch priorisiert, da diese zu einer Ausweitung der Nutzungszeit führen. Die so entstehende Diskursverzerrung zugunsten ökonomischer Interessen befördert auch die Verbreitung von Hassrede. Unter dem DSA wird eine solche Beeinflussung der gesellschaftlichen Debatte auf VLOPs erstmals als ein systemisches Risiko anerkannt. So legt Art. 34 Abs. 1 DSA unter anderem sowohl die Verbreitung rechtswidriger Inhalte als auch alle tatsächlichen oder absehbaren nachteiligen Auswirkungen auf die gesellschaftliche Debatte sowie in Bezug auf geschlechtsspezifische Gewalt als systemische Risiken fest.5

Dass Haugen nach ihren Enthüllungen von dem damals für den DSA federführenden Binnenmarktausschusses des EU-Parlaments eingeladen wurde, kann Anhaltspunkte liefern, um welche ‹nachteiligen› Auswirkungen auf die gesellschaftliche Debatte es gehen könnte: So wurde nach der Anhörung Haugens explizit das Geschäftsmodell von Sozialen Medien durch die Vorsitzende des Ausschusses problematisiert, welches «clicks, attention and sensation, not facts» priorisiere. Insbesondere polarisierende Hassrede sei ein Problem. Interessanterweise argumentiert Haugen in ihrer Anhörung, dass ‹mehr Transparenz› ein Schlüsselinstrument darstelle, um digitale Plattformen wie Facebook ‹sicherer› zu machen. Folgen wir der Spur des sich hier andeutenden Transparenz-Mythos und inwiefern er sich im mittlerweile in Kraft getretenen DSA wiederfindet.

Diese Spur führt uns zurück zur marktregulatorischen Perspektivierung des DSA: Da der DSA die Geschäftsmodelle Sozialer Medien problematisiert, wundert es nicht, dass insbesondere die Systeme der Inhaltsmoderation und algorithmischen Empfehlung in den regulatorischen Blick geraten. Denn es sind eben jene Systeme, die über den Profit der Plattformen, aber auch über die Ausübung der Meinungsfreiheit auf kommerzialisierten digitalen Öffentlichkeiten entscheiden.

Schon vor dem DSA haben Soziale Medien ‹Transparenz› als Legitimationsmittel genutzt. Sie betreiben dabei Transparency Washing und nutzen selektive Transparenz als öffentlichkeitswirksame Rhetorik, um durch die Veröffentlichungen von positiv konnotierten Einblicken in ihre Geschäfte von Skandalen abzulenken und Regulierungsbehörden zu vermitteln, sie wüssten nicht nur Bescheid, was auf den Plattformen wieso geschehe, sondern seien in der Lage einzugreifen. Stattdessen setzen die Unternehmen das Versprechen der Transparenz als Strategie im Sinne ihrer Profitmaximierung und als öffentlichkeitswirksames Marketing ein, um Regulierung proaktiv zu vermeiden. Transparenzinitiativen werden intentional eingesetzt, um letztlich Marktmacht zu verschleiern.6

Der DSA vermittelt bezüglich des Transparenzproblems zunächst Hoffnung, werden doch neue Transparenzauflagen insbesondere für VLOPs eingeführt. Doch auch der DSA geht dem Mythos der Transparenz auf den Leim. Dieser Mythos basiert auf der Vorstellung eines ‹schlanken Staats›, der lediglich die Rahmenbedingungen vorgibt. Rechenschaft gegenüber einem schlanken Staat bedeutet dann erst einmal nichts anderes für die Unternehmen als sich vermeintlich transparent zu machen. Ohne näher auf die Bedingungen einzugehen, die den Staat als ‹neutrales Instrument› erscheinen lassen oder die Rechenschaftsproblematik mit Judith Butler an dieser Stelle aufzumachen (Spoiler: es ist nicht möglich, vollständig Rechenschaft abzulegen und der Staat ist eben nicht neutral),7 stellt sich ein Mechanismus des DSA als zentral heraus: In einem komplizierten Aufsichtssystem sollen die Unternehmen regelmäßige Transparenzberichte veröffentlichen sowie die systemischen Risiken ermitteln, bewerten, teilen und mindern, die von den auf den Plattformen geteilten Inhalten ausgehen. Diese (Selbst-)Bewertungen werden von privatwirtschaftlich organisierten Audit-Organisationen geprüft, die in einer marktwirtschaftlichen Logik davon abhängig sind, dass es Unternehmen gibt, die sie zu bewerten haben, sprich: Sie sind abhängig von den Unternehmen, die sie überprüfen sollen. Die Europäische Kommission als zuständige Aufsichtsbehörde der VLOPs überprüft dann wiederum die Berichte. Da sie personell sowie sachlich kaum dazu ausgebaut ist, die Flut an produzierten Informationen auszuwerten, stellt sich durchaus die Frage, wie eine Regulierung von Seiten der Kommission gelingen kann. Der DSA sieht schließlich eine ‹regulierte Selbstregulierung› vor und die Transparenzberichte werden zum Heilsversprechen gelungener Regulierung und staatlicher Kontrolle.8

Indem durch Transparenzversprechen der Eindruck von Kontrolle (und damit: Sicherheit) vermittelt wird, dienen die Transparenzvorschriften letztlich also der Legitimierung der Kommerzialisierung von Öffentlichkeiten und verleiten demokratisch gewählte Institutionen dazu, Entscheidungen über Grundrechte und gesellschaftliche Werte an demokratisch nicht legitimierte Plattformen zu übertragen und deren Ausführung lediglich in begrenztem Maße zu überwachen.9 Fragen nach der grundsätzlichen Legitimation machtvoller, privat organisierter Plattformstrukturen sowie ihrer gewaltvollen gesellschaftspolitischen Effekte geraten damit in den Hintergrund. Es muss jedoch noch offenbleiben, welche Effekte der sehr komplexe und hier nur punktuell fokussierte DSA in Zukunft zeitigen wird und welchen Beitrag die gesetzliche Regulierung für die Sicherstellung eines demokratischen Miteinanders leisten kann.

Jenseits juridischer Fragen: Wo und wie ließe sich nun ein anderer Schauplatz für die Problematisierung und Politisierung digitaler Öffentlichkeiten finden?

Die Systeme zur Moderation zeitigen damit weitreichende Effekte für marginalisierte Institutionen und Personen(gruppen): Es sind eben jene, die potenziell stärker von der Unverfügbarmachung ihrer veröffentlichten Inhalte betroffen sind.

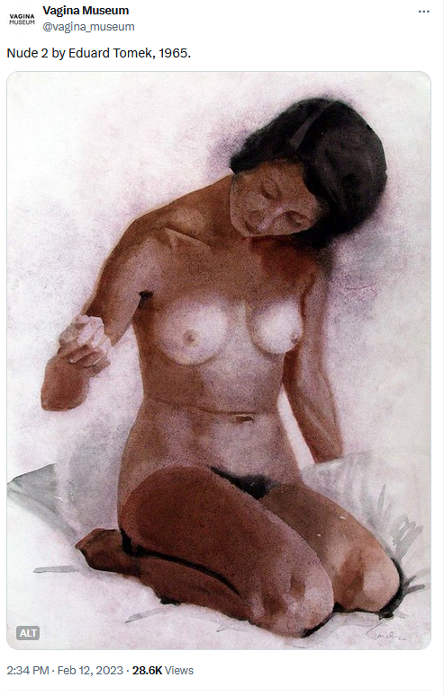

Zur Beantwortung dieser Frage möchten wir einen Blick auf eine Institution werfen, die sich in ihrer Vermittlung auf Social Media den Themen der Geschlechtsidentität und Sexualität annimmt und sich als ein Forum «for feminism, women’s rights, the LGBT+ community and the intersex community» versteht: Das Vagina Museum. Sofern wir unseren Blick insbesondere auf weiblich gelesene ‹Geschlechtsteile› wie die Klitoris richten die machtvollen Unsichtbarkeitsregimen und Zensurbewegungen unterliegen, dauert es nicht lange, um auf Posts des Vagina Museums stoßen, die als ‹sensibel› markiert und gefiltert werden.10 Das hier ausgewählte Beispiel ist dabei nur eines von Vielen und frau fragt sich zurecht, was daran nun so ‹anstößig› sein soll.

Screenshot, Orig. in Farbe: Hinweismarkierung ‹sensitive content› aus dem Twitter-Post vom Vagina Museum, 12.02.2023, https://x.com/vagina_museum/status/1624763754029150211.

Screenshot, Orig. in Farbe: Eduard Tomeks Nude 2 aus dem Twitter-Post vom Vagina Museum, 12.02.2023, https://x.com/vagina_museum/status/1624763754029150211.

Doch laut Museum sei es keine Seltenheit, dass auf Twitter Beiträge, die etwa das Wort Vagina enthalten, vom Algorithmus als obszön eingeordnet werden oder dass Beiträge, die die gynäkologische Anatomie im Allgemeinen betreffen oder LGBTQIA+-Identitäten bzw. -Lebensformen adressieren, gelöscht bzw. unverfügbar gemacht werden. Die Institution wird also durch Twitters Moderationspraxis in ihrer Vermittlung eingeschränkt und marginalisiert. Die Systeme zur Moderation zeitigen damit weitreichende Effekte für marginalisierte Institutionen und Personen(gruppen): Es sind eben jene, die potenziell stärker von der Unverfügbarmachung ihrer veröffentlichten Inhalte betroffen sind11 und deren Social Media Kanäle und Inhalte längst einem «Kampf um Sichtbarkeit» unterliegen. Zwar verweisen Plattformen im Zuge der Unverfügbarmachung von Inhalten mit knapp gehaltenen Hinweisen wie «your post may go against our guidelines on sexual activity or nudity» auf ihre allgemeinen Geschäftsbedingungen, wieso genau diese Beiträge nun jedoch als ‹anstößig› oder ‹sexualisiert› gelten sollen, bleibt bis zuletzt offen.

Vor diesem Hintergrund scheint es kaum verwunderlich, dass insbesondere Personen(gruppen) oder Institutionen, an die eben diese diskriminierenden und intransparenten normativen Maßstäbe angelegt werden, ihre Social-Media-Kanäle nutzen, um deren Effekte und Intransparenzen sowohl öffentlich sichtbar zu machen als auch zu politisieren. Dabei müssen wir jedoch zwei Effekte im Hinterkopf behalten, die uns zu einem grundlegenden Dilemma führen: Einerseits kann die Diskussion um die Inhaltsmoderation und algorithmisierten Empfehlungssystemen dem Geschäftsmodell der Plattformen in die Hände spielen. Denn durch die Skandalisierung ebendieser werden wiederum mehr Interaktionen der Nutzer*innen initiiert und damit auch wieder mehr Daten erzeugt, die wiederum den Plattformen für eine Optimierung ihrer Empfehlungssysteme – im Sinne einer zielgruppenspezifischen Adressierung – dienlich sind. Dennoch: Es eröffnen sich durch die Praxis der Sichtbarmachung bzw. Politisierung intransparenter Moderations- und Empfehlungssysteme andererseits auch Möglichkeiten, die zu einer Transformation desselbigen beitragen, indem etwa (informelles) Wissen darüber generiert wird, wie mit einer vermehrten Löschung von Beiträgen marginalisierter Gruppen kollaborativ umgegangen werden könnte. Es ist daher nicht selten der Fall, dass sich Nutzer*innen mit Blick auf die Löschung bestimmter Beiträge – durch kollektiv geteiltes Wissen bzw. geteilte Interessen im Sinne einer Community of Practice12 zusammenschließen. So weist das Vagina Museum an anderer Stelle etwa auf eine erfolgreiche Petition der Charity-Organisation The Eve Appeal für gynäkologische Onkologie hin, die das Wort und Hashtag #Vagina auf Instagram als ‹Schimpfwort› verbannte. Es ist eben jene Praxis des Community-Building, die somit von den Potenzialen zeugt, das Algorithmische und die ihm inhärente differentielle Gewalt in Bewegung zu halten sowie transformieren zu können. Dabei können auch Räume für diskriminierungssensible Inhalte geschaffen werden, die intersektional verschränkte Differenzkategorien wie race und gender sowie ihre Wirkweisen mitdenken.

Besonders relevant wird die zivilgesellschaftliche Sichtbarmachung und Verhandlung von Inhaltsmoderationen und algorithmisierten Empfehlungssystemen nun aber vor dem Hintergrund ihrer konkreten Politisierungen. So beispielsweise im Januar 2024 geschehen, als sich pornographische Deepfake-Bilder von Taylor Swift auf der Plattform X verbreiteten. 47 Millionen Views generierten die Bilder innerhalb kürzester Zeit. Doch auf die ‹Swifties› ist Verlass: Sie trugen maßgeblich zum massenhaften Flagging (also der Meldung der Bilder) bei und überfluteten die Plattform mit zahlreichen eigenen Beiträgen zum Thema und dem Aufruf «Protect Taylor Swift». Dies führte dazu, dass X die Bilder nicht nur entfernte und die Suche nach dem Namen des Popstars blockierte, sondern auch, dass die ursprünglichen ‹Deepfakes› aufgrund der Fanpostings kaum mehr aufzufinden waren. Und nicht nur das: Einige US-Politiker*innen fordern nach dem Vorfall neue Gesetze, um die Erstellung von Deepfake-Bildern unter Strafe zu stellen – was wiederum zeigt, dass zivilgesellschaftliche Politisierungen und rechtliche Regulierung nicht nur eng miteinander verbunden sind, sondern sich auch gegenseitig beeinflussen können. Es obliegt also weder ausschließlich staatspolitischen Regulierungen noch den Plattformen selbst, was wie(so) von wem oder was auf welche Weise (nicht) öffentlich wird.

Dieses differentielle Gewahrwerden, das einen Unterschied macht, fungiert gewissermaßen als eine Art infrastruktureller Glitch, als eine Störung, die die potenziell diskriminierenden Effekte digitaler Plattformen überhaupt erst offenbart und transformiert.

Auch wenn die Transparenzversprechen des DSA und die damit verknüpften, doch nicht einzuhaltenden Heilserwartungen zu problematisieren sind, kann festgehalten werden, dass die grundlegende Intransparenz bzw. Unverfügbarkeit (nicht nur) der komplexen Mechanismen zur Konfiguration digitaler Öffentlichkeiten auch Möglichkeitsräume für widerständige Praktiken und Politisierungen eröffnet. Das Ringen um die Intransparenz ist also nicht ausschließlich als Problem zu betrachten, sondern zeugt auch von produktiven Problematisierungsweisen: Es sind die Irritationen und Störmomente, die entstehen, wenn wir auf das hingewiesen werden, was wir gemeinhin gar nicht mitbekommen – in diesem Fall also die Moderation und Algorithmisierung von Content. Dieses differentielle Gewahrwerden, das einen Unterschied macht, fungiert gewissermaßen als eine Art infrastruktureller Glitch,13 als eine Störung, die die diskriminierenden Effekte digitaler Plattformen überhaupt erst offenbart und bestenfalls transformiert.

- 1

Wir danken insbesondere Hannah Ruschemeier für die intensiven Diskussionen zur Regulierung im Kontext des DSA und darüber hinaus.

- 2

Der Begriff der chilling effects bezeichnet den Umstand, dass aufgrund der Befürchtung von Sanktionen (durch Hassrede, aber auch durch staatliche Gewalt) User*innen weniger Gebrauch vom Recht auf freie Meinungsäußerung machen. Vertiefend und mit einem Fokus auf queere Communities vgl. Sergio Sulmicelli: Algorithmic content moderation and the LGBTQ+ community’s freedom of expression on social media: insights from the EU Digital Services Act, in: BioLaw Journal, Nr. 2, 2023, 471–489, doi.org/10.15168/2284-4503-2717.

- 3

Der fakultätsübergreifende Forschungsschwerpunkt digitale_kultur der FernUni in Hagen hat in eben diesem Sinne in der ersten Episode seiner Video-Reihe Theorie|Apparate die multiplen Bedingungen von ‹Hate Speech› im Plattformkontext aus interdisziplinärer Perspektive herausgearbeitet (produziert von Jennifer Eickelmann und Thorben Mämecke) und hält weiteres Infomaterial dazu für die Lehre bereit.

- 4

Marta Maroni: ‹Mediated transparency›: The Digital Services Act and the legitimisation of platform power, in: Maarten Hillebrandt, Päivi Leino-Sandberg, Ida Koivisto (Hg.): (In)visible European Government: Critical Approaches to Transparency as an Ideal and a Practice, London 2023, 305–326, hier 307–308; Hannah Ruschemeier: Wettbewerb der Aufsicht statt Aufsicht über den Wettbewerb? Kompetenzfragen der Plattformaufsicht aus verfassungsrechtlicher Perspektive, in: Johannes Buchheim u. a. (Hg.): Plattformen. Grundlagen und Neuordnung des Rechts digitaler Plattformen, Baden-Baden 2024, 227–248, hier 228.

- 5

Vgl. Ruschemeier: Wettbewerb der Aufsicht statt Aufsicht über den Wettbewerb, 235–236

- 6

Monika Zalnieriute: ‹Transparency Washing› in the Digital Age: A Corporate Agenda of Procedural Fetishism, in: Critical Analysis of Law, Jg. 8, Nr. 1, 2021, 139–153, hier 141,150–153, doi.org/10.33137/cal.v8i1.36284.

- 7

Judith Butler: Kritik der ethischen Gewalt, Frankfurt/M. 2014.

- 8

Zu den Aufsichtsstrukturen im DSA: Ruschemeier: Wettbewerb der Aufsicht statt Aufsicht über den Wettbewerb, 240, 243.

- 9

Maroni: ‹Mediated transparency›, 307, 315, 322.

- 10

Für eine differenzierte Darstellung unterschiedlicher Formen der Inhaltsmoderation siehe Isabelle Sarther: Infrastrukturen des Erinnerns und Vergessens. Content Moderation im Kontext musealer Vermittlung auf Twitter, Marburg 2024, i.E.

- 11

Vgl. Oliver L. Haimson u. a.: Disproportionate Removals and Differing Content Moderation Experiences for Conservative, Transgender, and Black Social Media Users: Marginalization and Moderation Gray Areas, in: Proceedings of the ACM on Human-Computer Interaction, Jg. 5., Nr. CSCW2, 2021, 1–35, doi.org/10.7302/2632.

- 12

Vgl. Geoffrey C. Bowker, Susan L. Star: Sorting Things Out. Classifications and Its Consequences, Cambridge, London 2000.

- 13

Lauren Berlant: The commons: Infrastructures for troubling times, in: Environment and Planning D: Society and Space, Jg. 34, Nr. 3, 2016, 393–419.

Bevorzugte Zitationsweise

Die Open-Access-Veröffentlichung erfolgt unter der Creative Commons-Lizenz CC BY-SA 4.0 DE.